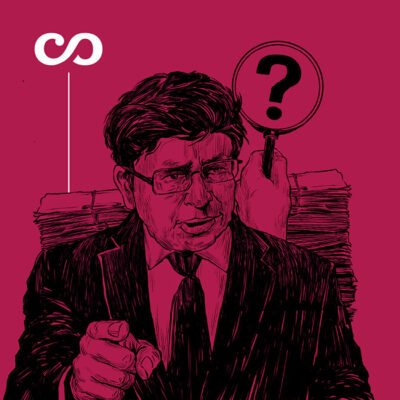

La imagen es fácil de suponer. El juez Manuel Padilla está rodeado de expedientes judiciales y todos le apuntan a la cabeza. Los digitalizados lo amenazan desde la pantalla del computador, mientras que los físicos —amarrados con cabuyas para no estallar— le recuerdan que los debe resolver pronto o el que irá a la cárcel será el juez y no el acusado. Aunque son las acciones de tutela, en realidad, las que lo llevan al borde del precipicio; las que lo empujan hacia el abismo del agotamiento. Por ley, cada una de ellas debe ser resuelta en un máximo de diez días.

En un juzgado como el de Padilla, el Primero Laboral del Circuito de Cartagena, hay un dato que presiona como soga al cuello. Cada mes, el despacho recibe en promedio entre cien y ciento veinte tutelas; es decir, debe resolver casi que seis al día. La justicia llega, pero cojea. Otro informe aprieta más el nudo: solo en 2023, en el país, se presentaron 742.888 tutelas, una cifra que estrangula, pues en Colombia apenas hay 5.500 jueces, 11 por cada 100.000 habitantes.

Tal vez por ello, en enero del año pasado, ante la asfixia laboral, Padilla se vio en la necesidad de ingresar a la plataforma de inteligencia artificial ChatGTP para hacerle cuatro preguntas sobre una tutela que lo agobiaba. El juez preguntó: «¿Un menor autista está exonerado de pagar cuotas moderadoras en sus terapias?, ¿las acciones de tutela en estos casos se deben conceder?, ¿exigir en estos casos la cuota moderadora es una barrera de acceso al servicio de salud?, ¿la jurisprudencia de la Corte Constitucional ha tomado decisiones favorables en casos similares?».

El caso de la tutela era, a grandes rasgos, el siguiente: una mujer había demostrado que su hijo tenía un trastorno de espectro autista, por lo que debía recibir tratamientos de rehabilitación en las áreas de psicología, terapia ocupacional y fonoaudiología. De modo que le solicitó a la EPS que la exonerara del pago y copago de cuotas moderadoras de salud. Cuando la EPS se negó, la mujer interpuso una tutela. En primera instancia un juzgado le dio la razón, pero la EPS impugnó y el caso llegó en segunda instancia al juzgado de Padilla, quien, ante el cúmulo de trabajo, echó mano de la inteligencia artificial para dar su veredicto.

Spoiler: el juez Padilla confirmó la sentencia de primera instancia. Le ordenó a la EPS prestarle al niño las terapias de rehabilitación sin pago o copago alguno y, además, suministrar el servicio de transporte al menor las veces que lo requiriera. El expediente, como ocurre con todas las tutelas, fue enviado a la Corte Constitucional para su posible revisión. Este alto tribunal confirmó las dos sentencias anteriores, pero seleccionó el caso por la novedad en la que había incurrido el juez Padilla: el uso de la inteligencia artificial en la toma de una decisión judicial.

Los magistrados que insistieron en seleccionar la tutela fueron Paola Andrea Meneses y José Fernando Reyes. Ambos tenían varios interrogantes, aunque su inquietud principal era si esta decisión la había emitido un juez de la república o un programa de inteligencia artificial. Es probable que a los dos togados también los invadiera el miedo de que, en este presente que ya no es futuro, las máquinas y los robots los empezaran a reemplazar en la toma de decisiones.

La escena también es predecible: los togados, recordando con susto películas distópicas como Dredd (2012), en la que la ley la regulan las máquinas; o RoboCop (1987), donde un cyborg tiene la capacidad de actuar como juez y ejecutor; o aquella película de George Lucas, THX 1138 (1971), en la que las máquinas son agentes de control social y justicia. Los magistrados, entonces, consideraron imperioso revisar una posible vulneración al derecho fundamental al debido proceso, entendiendo que en Colombia aún no se había estudiado de fondo un caso como este.

En su defensa, el juez Padilla, quien ahora era el examinado, argumentó que solo empleó las herramientas de inteligencia artificial para extender los argumentos de la decisión adoptada. Dijo que su deseo era optimizar los tiempos empleados en la escritura de la sentencia. Y quizá tenía razón: no hay nada más difícil que escribir, y más cuando se trata de dictar sentencias. Padilla insistió, a lo mejor tan asustado como los acusados a los que suele absolver o condenar, que fue él mismo quien tomó la decisión judicial y no ChatGPT. Aseguró que usó el método clásico de razonamiento judicial. La inteligencia artificial fue un complemento, no un actor principal.

Los magistrados se vieron obligados a profundizar sus conocimientos sobre la inteligencia artificial. Tal vez por ello aprendieron que su desarrollo más cercano inició en la década de 1950, cuando el psicólogo estadounidense Frank Rosenblatt inventó el primer gran modelo de red neuronal, un sistema de computación inspirado en el cerebro humano que aprendía a reconocer patrones para tomar decisiones mediante capas de nodos interconectados que almacenaban datos. Algo parecido a neuronas comunicándose a la velocidad de la luz para arrojar respuestas a la velocidad de la lengua.

Muy pocas cosas han asustado tanto a los humanos como los alcances de esta tecnología. Entre 2018 y 2022, el investigador Sam Altman y su equipo lograron crear un hardware, una máquina, que se podía alimentar y entrenar con grandes cantidades de texto disponibles en internet, incluidos libros, artículos y páginas web, para así generar respuestas en lenguaje natural a partir de texto, simulando una conversación humana. La máquina respondía casi todo lo que se le preguntaba. La llamaron ChatGPT (el GPT es por Generative Pre-trained Transformer; es decir, Transformador Generativo Preentrenado).

Sin embargo, ChatGPT no ha funcionado a la perfección, y eso ha producido incluso más miedo. Los jueces lo sabían. En el estudio de la sentencia surgió otra inquietud. Los magistrados quisieron comprobar si la decisión fue debidamente motivada o si fue producto de las alucinaciones y los sesgos que a veces genera la inteligencia artificial. «Alucinaciones», ese es el término que los expertos utilizan para las mentiras que dice la IA cuando no tiene una respuesta correcta, pero aún así la máquina alucina porque no quiere perder. Los «sesgos», por otro lado, se refieren a que la máquina podría alimentar sus respuestas con documentos publicados en internet que contienen estereotipos, posturas discriminatorias o juicios parcializados.

La sala que revisó el caso encontró correctas las respuestas que ChatGPT le dio al juez Padilla respecto de la tutela que buscaba proteger los derechos del niño. Aun así, el alto tribunal ordenó que el Consejo Superior de la Judicatura emitiera una guía o lineamientos para el uso razonable y proporcional de herramientas como la inteligencia artificial. El hecho fue noticia en Colombia y en todo el mundo. La Corte aceptó el uso de la IA, pero como ayuda, no como determinador.

El magistrado Juan Carlos Cortés, quien estuvo al frente de la sentencia, habló sobre el caso en una extensa entrevista con la Revista Cambio. Allí advirtió que la inteligencia artificial no podía reemplazar a los jueces, que estos debían exponer si en sus fallos utilizaron estas herramientas, que por transparencia se debían identificar los resultados utilizados, que por responsabilidad se debía reconfirmar si los datos suministrados por la IA eran correctos y que por privacidad se debía evitar que estas herramientas revelaran la intimidad de los usuarios del servicio público de administración de justicia.

Pero todo indica que la amenaza no está en la IA, sino en quién la usa y en cómo la utiliza. En casa de herrero… Hace tres meses se supo que la fascinación de Sam Altman por Scarlett Johansson había llegado a un ancho de banda inusitado. El CEO de ChatGPT le propuso a la actriz que fuera la voz del asistente personal de esta inteligencia artificial, pero ella se negó. La idea surgió porque Johansson protagonizó la película Her (2013), en la que un hombre (Joaquin Phoenix) se enamora de una inteligencia artificial que tiene la voz y la conciencia de una mujer (Johansson).

Luego se descubrió que Her era la película preferida de Altman y que este quiso hacerla realidad sin el consentimiento de la actriz. De modo que un programa imitó la voz de ella y la pusieron a funcionar sin su permiso. Scarlett Johansson se opuso rotundamente, demandó a la compañía y en cuestión de millones de gigabytes por segundo la voz desapareció de internet y del proyecto al que Altman había llamado Sky. El CEO de ChatGPT ya había tenido problemas con su propia empresa OpenIA: en noviembre de 2023 fue expulsado de esta por no haber suministrado toda la información sobre la vertiginosa velocidad a la que estaba avanzando la inteligencia artificial. Velocidad que ahora también tiene asustados a jueces y magistrados, quienes desean impedir que las máquinas emitan el juicio final.